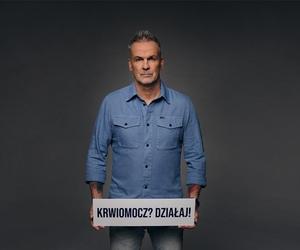

- Mężczyzna, który chciał zredukować spożywanie soli, poprosił czat GPT o podanie zamienników

- Chatbot OpenAI zaproponował bromek sodu - substancję, która może powodować m.in. zaburzenia neurologiczne

- U mężczyzny doszło do poważnego zatrucia organizmu i zaburzeń psychicznych, które wymagały hospitalizacji w szpitalu psychiatrycznym

Ludzie pytają czat GPT o wszystko

Rozmawiacie z czatem GPT? Mówicie mu, co czujecie? Szukacie odpowiedzi na pytanie, na co chorujecie? Nie jesteście w tym sami – coraz więcej osób przyznaje się do korzystania z czata GPT w coraz szerszym wymiarze.

Jednak część osób idzie w tej relacji za głęboko – były już doniesienia o osobach, które „zakochiwały się” w czacie.

Są też osoby, które bezkrytycznie kopiują wszystko, co czat podpowie – później możemy przeczytać takie „wpadki”, także w niektórych serwisach w sieci, gdzie pojawiały się, przykładowo, odniesienia do nieistniejących publikacji lub umieszczanie informacji niezgodnych z prawdą.

Social media żyją w tym zakresie własnym życiem, coraz częściej powstają posty o zdarzeniach i osobach, których nigdy nie było – i są szeroko szerowane, bez weryfikacji, bez refleksji.

Czy można używać AI jako lekarza?

Nie inaczej bywa w przypadku chorób: medycy coraz częściej alarmują, że pacjenci podważają ich kompetencje, bo czat GPT ma odmienne zdanie co do diagnozy, albo przychodzą od razu z diagnozą postawioną przez sztuczną inteligencję.

Tym razem korzystanie z AI stało się przyczyną hospitalizacji. Pacjent wymagał pomocy w szpitalu psychiatrycznym. Jak do tego doszło?

Mężczyzna, który – co się chwali – chciał poprawić swój stan zdrowia. Jednak zamiast pójść w tym celu do lekarza i dietetyka, podobnie jak wiele osób, pechowy pacjent skonsultował się z „doktorem AI”.

I dostał to, czego chciał: czyli plan zdrowotny od chatbota. Efekt? Doszło do rzadkiego zatrucia, co spowodowało poważne zaburzenia.

7 wspomagaczy nastroju, które nic nie kosztują

Czat GPT podpowiedział, żeby jeść trujący środek

A zapowiadało się naprawdę dobrze: pacjent chciał ograniczyć spożycie soli (co się chwali). Szukał w tym celu zamienników. Problem w tym, że Chatbot OpenAI zaproponował bromek sodu. Pacjent zamówił ten preparat w sieci i... zaczął dorzucać do potraw.

Bromek sodu bywa używany np. do czyszczenia. Jest to sól sodowa kwasu bromowodorowego, wykorzystywana w chemii i przemyśle farmaceutycznym. W przeszłości stosowano go jako lek uspokajający i przeciwdrgawkowy, ze względu na działanie depresyjne na ośrodkowy układ nerwowy.

Obecnie zastosowanie bromku sodu w medycynie jest ograniczone, a częściej używa się go w syntezach chemicznych i produkcji innych związków bromowych.

Bromek sodu jest dobrze rozpuszczalny w wodzie i krystalizuje w postaci białych kryształów. Substancja ta powinna być stosowana ostrożnie, ponieważ przedawkowanie może prowadzić do bromizmu, objawiającego się m.in. zaburzeniami neurologicznymi.

Pacjent trafił do szpitala psychiatrycznego po poradach AI

Nie dziwi więc dalszy rozwój akcji: 3 mies. później pacjent trafił na oddział ratunkowy, doświadczając m.in. urojeń i paranoi, że sąsiad chce go otruć.

- W ciągu pierwszych 24 godzin od przyjęcia do szpitala pacjent przejawiał narastającą paranoję oraz halucynacje słuchowe i wzrokowe, które po próbie ucieczki doprowadziły do przymusowego leczenia psychiatrycznego z powodu ciężkiego kalectwa.

– zrelacjonowali lekarze opiekujący się mężczyzną. Poprawę przyniosły leki przeciwpsychotyczne. Wówczas przeprowadzono wywiad, a także badania, które potwierdziły, że pacjent zmagał się z bromizmem.

U większości zdrowych osób stężenie bromku w organizmie jest bardzo niskie – zwykle poniżej 10 mg/l. W opisywanym przypadku pacjent miał aż 1700 mg/l, co świadczyło o bromizmie – schorzeniu wynikającym z nadmiernego spożycia bromków.

Na początku XX wieku bromizm był dość częsty i odpowiadał za nawet 8 proc. wszystkich hospitalizacji psychiatrycznych. Jednak wraz z wycofywaniem leków zawierających bromki w latach 70. i 80. XX wieku, liczba przypadków drastycznie spadła.

Dlaczego lepiej nie leczyć się w internecie

Specjaliści zaznaczają, że ten przypadek pokazuje, iż nawet najbardziej zaawansowana technologia, jak sztuczna inteligencja, nie zastąpi w pełni doświadczenia i wiedzy lekarza w diagnozowaniu oraz leczeniu rzadkich czy nietypowych schorzeń.

- Należy pamiętać, że ChatGPT i inne systemy oparte na sztucznej inteligencji mogą generować nieścisłości naukowe, nie potrafią krytycznie omawiać wyników i ostatecznie przyczyniają się do rozprzestrzeniania dezinformacji.

Jest bardzo mało prawdopodobne, aby ekspert medyczny wspomniał o bromku sodu, mając do czynienia z pacjentem szukającym skutecznego zamiennika chlorku sodu

- wyjaśnili autorzy studium przypadku. Pacjent był leczony przez trzy tygodnie i został wypisany do domu bez poważniejszych powikłań.